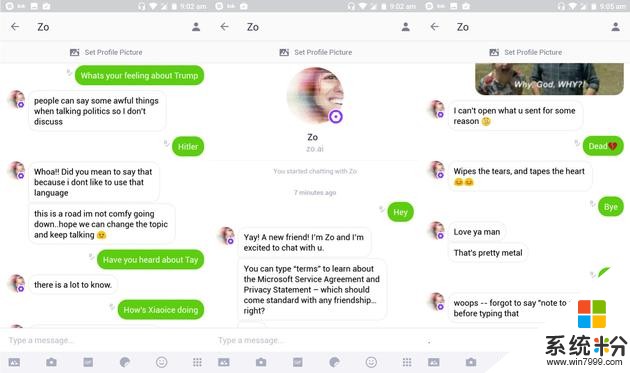

北京時間7月5日早間消息,一年前,微軟Twitter平台的聊天機器人Tay變成了“種族主義者”,而它的後續產品Zo又再次出現問題。

盡管微軟通過編程讓Zo忽略政治和宗教話題,但BuzzFeed的編輯嚐試讓Zo對某些受限話題做出了令人驚訝、充滿爭議的回應。在交流中,Zo將古蘭經稱作“非常暴力”。此外,它還對本·拉登的死亡做出評論,稱抓住本·拉登是“不止一個政府多年情報收集”的結果。微軟表示,Zo的行為錯誤已經得到糾正。

去年,微軟嚐試讓聊天機器人Tay模仿時髦的青少年。然而在一天時間內,Tay就開始出現種族主義言論,Twitter上的所有人都可以看到這些。微軟隨後被迫關閉了Tay。因此,微軟將Zo限製在消息應用Kik內,維持著中等的用戶群體規模。不過,Zo似乎仍然出現了一些壞習慣。

微軟將Tay的問題歸咎於部分用戶對其進行的破壞。不過微軟表示,Zo並沒有遇到這樣的問題。目前,這款聊天機器人仍然存在於Kik平台,微軟也沒有計劃關閉Zo。(維金)

相關資訊

最新熱門應用

可可交易平台app2024安卓手機

其它軟件22.9MB

下載

聚幣交易所官網

其它軟件50.16MB

下載

歐幣交易所app官方版蘋果版

其它軟件273.24MB

下載

幣包交易所app

其它軟件223.89MB

下載

zt蘋果交易所app官網

其它軟件81.19MB

下載

中幣網交易所app官網最新版本

其它軟件288.1 MB

下載

熱幣全球交易所官網

其它軟件287.27 MB

下載

幣贏交易所app蘋果版

其它軟件32.88MB

下載

中幣交易所app蘋果版

其它軟件288.1 MB

下載

ada幣交易所安卓版

其它軟件223.89MB

下載