AI會成為種族主義者嗎?好吧,這得看情況。假設你是一名在學校讀書的非裔美國人,在該學校要使用麵部識別軟件進入大樓和訪問在線家庭作業。這時候軟件出了一個問題:學校此前隻用淺膚色測試了軟件算法。你膚色有些黑,因此軟件在識別你時經常有問題。

你有時會遲到,有時甚至不能按時完成作業,使得你成績不好。這一結果就是僅因膚色導致的歧視。雖然這不是真實案例,但類似的AI失策在科技業和社交圈已經聲名狼藉。行業對AI興奮的理由很充分——大數據和機器學習帶來了幾年以前無法想象的強大體驗。

但對AI而言,要實現承諾就要保證,係統必須是可信的。人們的信任感越強,與係統交互次數也就越多,係統也就能使用更多數據來給出更好的結果。但信任需要花費很長時間來培養,偏見卻可以瞬間摧毀它,並給社區造成真正的傷害。

認識AI中的排外

在微軟,工作人員開發了包容性的設計工具和流程,從而能在設計流程識別殘障人士。通過實踐進化,微軟將這種設計思維擴展到了其他排外領域,包括認知問題,學習方式偏好和社會歧視。對AI而言,現在是時候采用同樣的方法了。

如果建立(係統)之初沒意識到包容性,AI偏見就會發生。創建包容性AI最重要的步驟是,認識到偏見在哪兒,以及如何影響係統。包容性設計的第一個原則就是認識到排外。本文的介紹指南將AI偏見分解成不同類別,因此產品創造者能在早期發現問題,預測未來的問題,並在途中做出更好決定。通過讓團隊清晰看到係統在哪兒出錯,能幫助他們識別偏見(identify bias),並建立兌現AI對所有人承諾的體驗。

識別偏見的五種方式

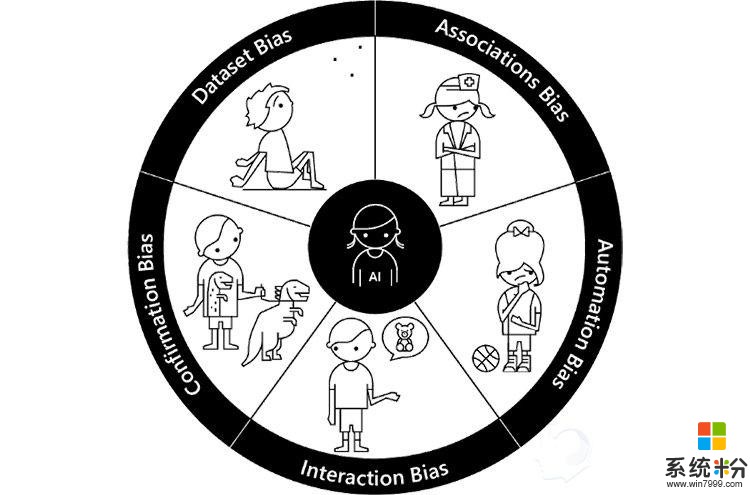

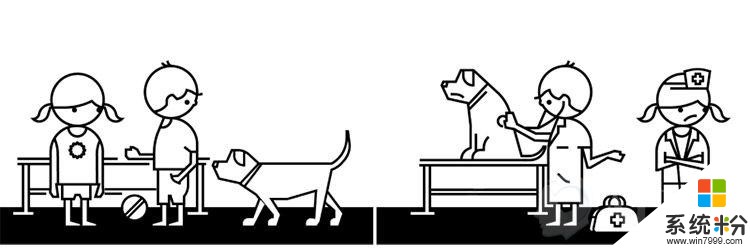

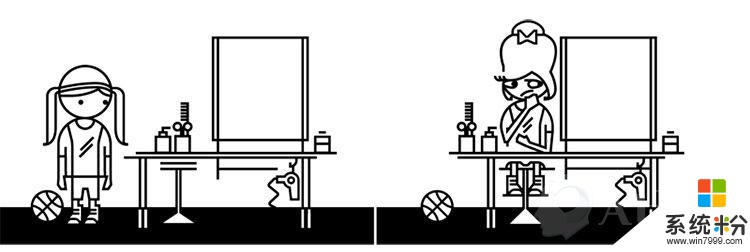

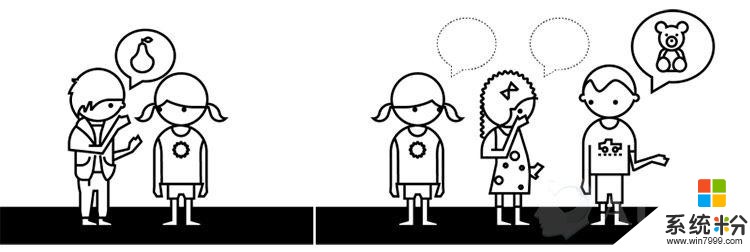

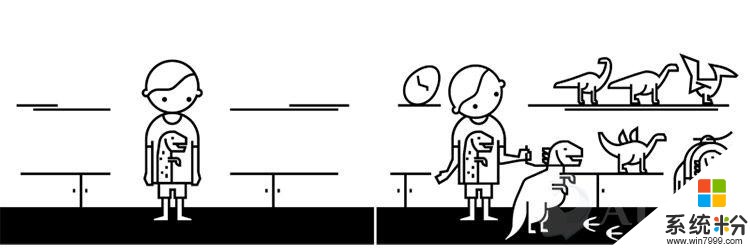

通過與學術和行業思想領袖共同合作,微軟確認了5種方式來識別偏見。然後,微軟用童年情景作為隱喻來說明每個類別中的行為。為什麼要這樣做呢?我們可以將童年經曆和偏見聯係起來,並且與這個比喻很貼切:AI還在起步階段,就像兒童那樣,它的成長反映了我們如何培養和養育它。

通過首先解決這5種偏見,能創造更多包容性產品

每一個偏見分類(分解圖如上)都包括了一個童年隱喻,包括定義,產品案例,以及團隊和AI工作要麵臨的壓力測試。

數據偏見

兒童會純粹地依據能看到的少量(世界)來定義世界。最終,孩子們會學習到,大部分世界超越了他們視野範圍能看到的少量信息。 這是數據偏差的根源:AI依賴的信息太小了,或者說太同質。

定義:給機器學習模型訓練用的數據不能代表客戶群的多樣性。大規模數據集是AI的基礎。同時,數據集會被縮減成沒考慮各種用戶的概述,無法真實地反映他們。

產品案例:機器視覺技術——如跟蹤用戶動作的網絡攝像頭——隻適用於基於種族的小群用戶(主要是白種人),因為最初的訓練數據排除了其他種族和膚色。

壓力測試:如果你正使用一個訓練用數據集,那麼這個樣本包含你客戶群的所有人嗎?如果沒有的話,你是否測試了未包含在樣本中用戶的使用結果?你AI團隊中的人是否包容、多樣和敏感,從而能識別偏見呢?

團體偏見

想象一下那些喜歡玩“醫生遊戲”的孩子。男孩想要扮演醫生,並假定女孩會扮演護士。女孩必須自己來打破這一假設,“嘿,女孩也能當醫生呀。”

定義:訓練AI模型的數據強化和增加了文化偏見。當訓練AI算法時,人類偏見可對機器學習產生影響,保留這些偏見可能會在未來互動中導致不公平的客戶體驗。

產品案例:語言翻譯工具會帶來性別假設(如飛行員——pilot——是男士,空中服務員——flight attendant——是女士。

壓力測試:你的結果是否讓團隊永久定型了性別或種族?為了打破不良和不公正的團體,你該做什麼?你的數據集已經分類和標記了嗎?

自動化偏見

想象一個要進行打扮的女孩。這個女孩喜歡運動,喜歡自然的外觀,並討厭任何人為的。但美容師對她的美麗有不同想法,給她用了許多化妝品,並設計了繁瑣的發型。這個結果雖然讓美容師開心了,卻讓女孩感到恐怖。

定義:自動決策超越了社會和文化因素。預測程序自動完成的目標可能違背人類多樣化,這些算法並不是對人類負責,而是在人的影響下做出決定。AI設計師和從業者要考慮其係統對人們目標的影響。

產品案例:美化照片濾鏡在麵部圖像上強化歐洲人的美容觀念,如減輕皮膚色調。

壓力測試:真正的,形形色色的顧客真地同意你算法給出的結論嗎?AI係統是否拒絕人類決定,更傾向於自動化決定?你如何保證係統中有人的視角?

互動偏見

有個非常流行的兒童遊戲“打電話”。團隊中的第一個小朋友把一句話告訴下一位,然後這個人以同樣方法傳遞給下一個,直到告訴最後一人,並說出他聽到的話。這裏的關鍵是觀察經過多次自然傳遞後,信息會發生什麼樣的改變。但如果一個孩子故意改變它的話,會帶來更荒唐的結果。雖然這可能會很有趣,但觀察事情自然發生的願望就破碎了。

定義:人類篡改AI並產生有偏見的結果。現在的聊天機器人能講笑話和愚弄人們,讓人類認為它們是人。但許多嚐試賦予AI人性的實驗,都在無意間製造出被有毒人類偏見汙染的電腦程序。當機器人在沒有保護措施情況下開始廣泛學習時,互動偏見就會出現。

產品案例:人類故意將種族或性別歧視的語言教給聊天機器人,讓機器人開始說讓人反感的東西。

壓力測試:你有沒有檢查麵向係統的惡意傾向?你的AI係統從人們那兒學了什麼?你設計了實時交互和學習功能嗎?AI反饋給客戶的到底意味著什麼?

證實偏見

想象一下收到玩具恐龍作禮物的小孩吧。其他家庭成員看到了這個恐龍,並送給了他更多恐龍。幾年後,朋友和家庭成員假設他是一個恐龍愛好者,並持續不斷給他更多恐龍,直到他擁有巨大收藏。

定義:過度簡化個人特性會產生對一個群體或個人的偏見假設。證實偏見會傾向於尋找支持先入為主想法的信息。AI算法會提供匹配人們已經選擇的內容,這排除了那些不受歡迎的選擇。這不利於看到與個人想法對立的觀點,阻止你看到不同想法和備選方案。

產品案例:購物網站推薦的東西經常是顧客已經買過的。

壓力測試:你的算法是否建立在流行選項,強化了這些選擇?隨著時間推移,你的AI能依據用戶改變做出動態演算嗎?你的AI係統能讓顧客以更多樣和包容的視覺看世界嗎?

未來還很長

以上是微軟作為AI設計師和創造者的一些經驗,涉及AI如何進化,以及AI如何影響真實的人。而這僅僅是漫漫長路的開始——一創造出這樣一種體驗,AI能平等服務所有人。

回到文章最初提到的非裔美國人例子,我們可以將其標記為數據偏見:因為這個麵部識別軟件使用的訓練數據過於狹窄。如果一開始就能識別和理解這些偏見,我們就能在考慮別人想法的情況下測試係統,並創造更包容的體驗。我們的麵部識別軟件是否受製於錯誤數據?又有哪些偏見會影響到使用體驗呢?

許多AI領域工作的人都會遇到這種類似的軼事證據。但令人尷尬的是,無意的偏見會產生令人不快的結果,雖然這是我們希望識別和避免的。借助本文提到的方法,有助於幫助開發者認識可能導致上述狀況的潛在偏見:以上述分類開始測試下你的經驗,看思維中是否存在這些偏見,這能讓你更好地專注於為所有客戶提供AI的潛能。

相關資訊

最新熱門應用

威海公交車官方app安卓版

旅行交通109.7M

下載

運滿滿司機版app官方版

生活實用102.7M

下載

小猿口算app安卓最新版

辦公學習71.96MB

下載

樂速通app官方最新版

生活實用168.55MB

下載

墨趣書法app官網最新版

辦公學習52.6M

下載

光速寫作軟件安卓版

辦公學習59.73M

下載

中藥材網官網安卓最新版

醫療健康2.4M

下載

駕考寶典極速版安卓app

辦公學習189.48M

下載

貨拉拉搬家小哥app安卓版

生活實用146.38M

下載

烘焙幫app安卓最新版

生活實用22.0M

下載