機器之心發布

作者:Weijie Su、Xizhou Zhu、Yue Cao、Bin Li、Lewei Lu、Furu Wei、Jifeng Dai

為了讓 VL-BERT 模型利用更為通用的特征表示,作者在大規模圖片描述生成數據集 ConceptualCaptions 中進行 VL-BERT 的預訓練,實驗證明此預訓練過程可以顯著提高下遊的視覺-語言任務的效果,包含視覺常識推理、視覺問答與引用表達式理解等。值得一提的是,在視覺常識推理排行榜中,VL-BERT 取得了當前單模型的最好效果。

論文地址:https://arxiv.org/abs/1908.08530

適用於下遊任務的通用特征表示預訓練是深度網絡成功的標誌之一。在計算機視覺領域,深度網絡在 ImageNet 數據集進行圖像分類的預訓練過程,被發現可廣泛提高多種圖像識別任務的效果。在自然語言處理領域中,Transformer 模型在大規模語料庫中使用語言模型進行預訓練的過程,也被證明可廣泛提高多種自然語言處理任務的效果。

但對於計算機視覺和自然語言處理領域交叉的任務,例如圖像標題生成、視覺問答、視覺常識推理等,缺少這種預訓練的通用多模態特征表示。

一般來說,之前的視覺-語言模型分別使用計算機視覺或自然語言處理領域中的預訓練模型進行初始化,但如果目標任務數據量不足,模型容易過擬合從而損失性能。並且對於不同的視覺-語言任務,其網絡架構一般是經過特殊設計的,由此很難通過視覺-語言聯合預訓練的過程幫助下遊任務。

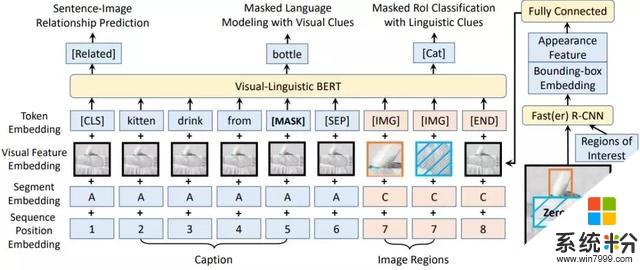

由此,在本文中,作者提出了一種可廣泛應用於視覺-語言任務的預訓練通用特征表示,稱為 Visual-LinguisitcBERT,簡稱 VL-BERT,其架構如下圖所示:

VL-BERT 的主幹網絡使用 TransformerAttention 模塊,並將視覺與語言嵌入特征作為輸入,其中輸入的每個元素是來自句子中的單詞、或圖像中的感興趣區域(Region of Interests,簡稱 RoIs)。在模型訓練的過程中,每個元素均可以根據其內容、位置、類別等信息自適應地聚合來自所有其他元素的信息。在堆疊多層 TransformerAttention 模塊後,其特征表示即具有更為豐富的聚合與對齊視覺和語言線索的能力。

為了更好地建模通用的視覺-語言表示,作者在大規模視覺-語言語料庫中對 VL-BERT 進行了預訓練。采用的預訓練數據集為圖像標題生成數據集,Conceptual Captions,其中包含了大約 330 萬個圖像標題對。

VL-BERT 的預訓練主要采用三個任務:a) 屏蔽語言模型(Masked Language Modeling),即隨機屏蔽掉語句中的一些詞,並預測當前位置的詞是什麼;b) 屏蔽 RoI 分類(MaskedRoIClassification),即隨機屏蔽掉視覺輸入中的一些 RoIs,並預測此空間位置對應 RoI 的所屬類別;c) 圖像標題關聯預測(Sentence-Image Relationship Prediction),即預測圖像與標題是否屬於同一對。

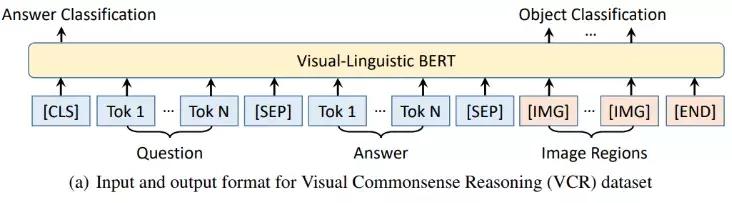

在預訓練結束後,使用微調來進行下遊任務的訓練。本文中主要在三個視覺-語言下遊任務中進行微調,即視覺常識推理(VisualCommonsenseReasoning)、視覺問答(VisualQuestionAnswering)與引用表達式理解(ReferringExpressionComprehension),下麵將分別介紹。

視覺常識推理任務即給定圖片與相關問題,機器不僅需要回答問題,還需要提供理由來證明答案的正確性。此任務(Q->AR)被分解為兩個子任務,即視覺問答(Q->A,給定圖片與問題,輸出正確答案),以及視覺推理(QA->R,給定圖片、問題與答案,輸出正確的理由)。

下麵以視覺問答子任務為例,此任務的輸入為問題、答案與圖像的 RoIs,並預測此答案是否為正確答案。除此之外,作者發現微調時增加與預訓練類似的 RoI 分類損失也會進一步提升性能,如下:

視覺問答任務即給定圖片,回答與圖片輸入相關的問題。由此模型的輸入即為問題與圖像,基本元素為單詞或 RoI,最終對答案進行預測,如下:

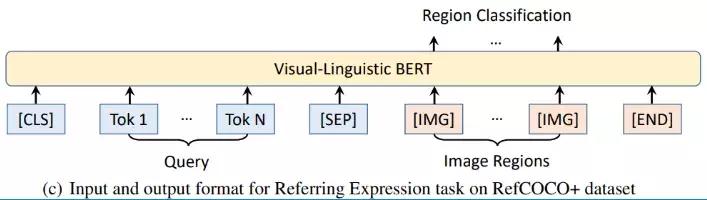

引用表達式理解任務是使用給定的引用表達式來定位圖像中的相關對象,由此輸入為查詢(引用表達式)與圖片中的 RoIs,並預測哪個 RoI 為查詢輸入的引用,如下:

下麵將介紹論文中的一些主要實驗結果:

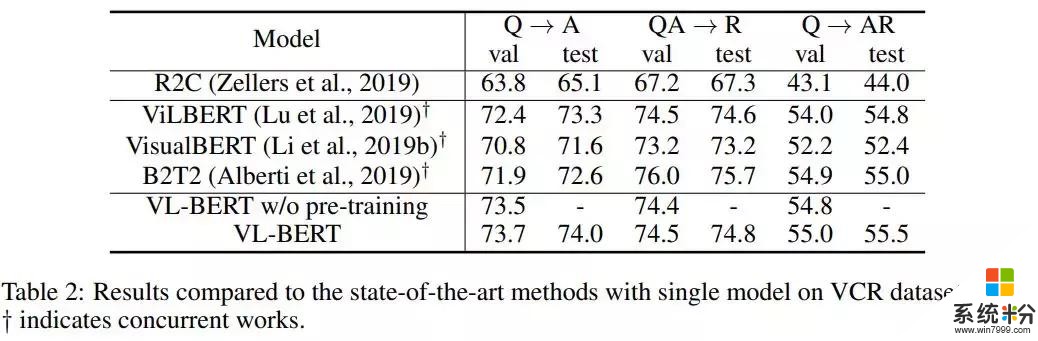

a)在視覺常識推理(Visual Commonsense Reasoning)任務中,與當前最好方法的結果比較如下:

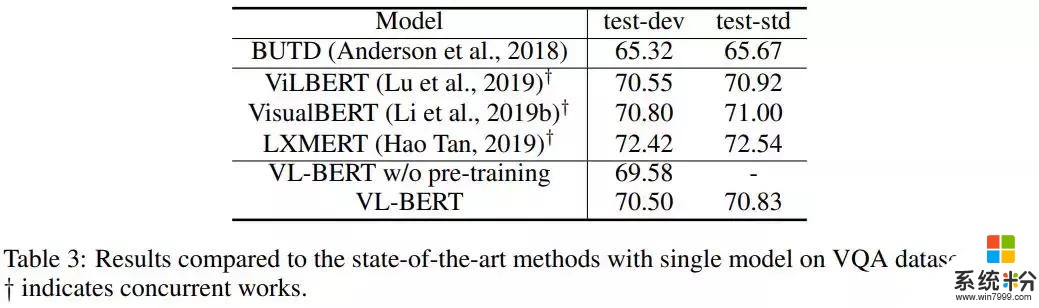

b)在視覺問答(Visual Question Answering)任務中,與當前最好方法的結果比較如下:

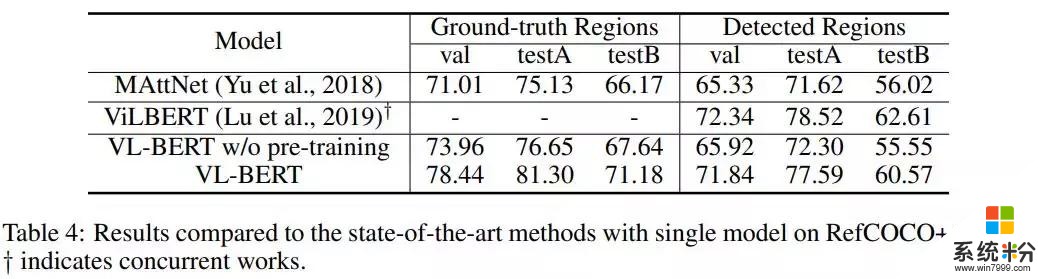

c)在引用表達式理解(Referring Expression Comprehension)任務中,與當前最好方法的結果比較如下:

相關資訊

最新熱門應用

必安交易所app官網版蘋果版

其它軟件88.66MB

下載

易付幣交易所

其它軟件108.01M

下載

區塊鏈交易所app官網蘋果手機版本

其它軟件292.97MB

下載

ave交易平台官網

其它軟件292.97MB

下載

theta交易所

其它軟件223.89MB

下載

熱幣交易所app蘋果版

其它軟件50.42MB

下載

比特幣交易app官網安卓手機

其它軟件179MB

下載

最新版zb交易平台app

其它軟件223.89MB

下載

芝麻app交易平台蘋果版

其它軟件223.89MB

下載

熱幣全球交易所app官網版安卓

其它軟件175.43 MB

下載