【智能觀】如何識別AI產生的偏見呢?微軟包容性設計團隊發現,培養AI和培養小孩子如出一轍,而孩子童年玩遊戲中表現出的一些無意識的偏見和AI產生的偏見也很想象。因此,他們通過研究小孩子玩遊戲提出五種識別AI偏見的方法,並提供了這份指南。

話說有一天,X學校開始使用麵部識別軟件記錄考勤,登陸在線作業係統。但是軟件有一個bug,它的製造者隻使用了淺膚色人群的測試樣本來訓練算法。不幸的是,你恰好是名非裔學生。由於膚色的原因,軟件很難識別你,因此,它判你上課遲到,說你沒有按時完成作業。軟件怎麼會出錯呢?受到影響的隻有你的成績。

曾有人疑惑,人工智能是怎麼成為種族主義者的呢?上述就是人工智能對膚色歧視的例子。雖然這並不是真實案例,但類似的人工智能偏見已經在科技行業和社交媒體上飽受詬病。

科技行業現在一談人工智能就很high,大數據和機器學習給了人們幾年前難以想象的強大體驗。但AI想要完美地實現人們的願景,其係統必須是值得信賴的。因為人們的信任越多,他們與係統的交互就越多,係統就會獲得更多數據,得到更好的結果。但信任需要很長時間才能建立,偏見卻可以瞬間將其摧毀。

認識人工智能的排外行為

人工智能的確會出現偏見,除非從它設計之初就有比較完善的模型。創建包容性的人工智能最關鍵的一步是認識到偏見是如何影響係統的。

包容性設計的首要原則是確認排外行為,本文也將AI偏見分為不同的類別,方便產品製造者及早發現問題,預見未來會出現的問題,並做出更好的決策。借助本文,AI團隊可以清楚地看到自己的係統哪裏出了問題,這樣他們就能識別偏見,並積累經驗,實現AI對每個人都公平的承諾。

五種識別偏見的方法

我們與學術界、製造業的一些思想領袖合作,確定了五種識別偏見的方法。接下來,我們會使用孩子們的經曆來解釋這些行為。為什麼把AI產生的偏見和孩子童年產生的偏見聯係在一起呢?其實這是一個很好的比喻:人工智能正處於起步階段,就像孩子一樣,它如何成長,取決於我們如何培養和培育它。

每一個偏見類別都有一個童年隱喻,包括定義、產品示例,以及團隊和AI工作麵臨的壓力測試。

1. 數據集的偏見

年幼的孩子會認為自己眼中看到的就是整個世界。漸漸地,世界上的大部分信息都在他們的視野之外。這是數據集偏見的根源:信息太少、太單一。

定義:用於培訓機器學習模型的數據無法代表基礎用戶的多樣性。大型數據集是人工智能的基礎。與此同時,數據集常常被簡化成一般化的理想模型,不能充分考慮用戶的特殊性,因此代表不了全體用戶。

產品示例:機器視覺技術,如跟蹤用戶移動的網絡攝像頭,隻能用於部分群體(主要是白人),因為最初的訓練數據排除了其他種族和膚色。

壓力測試:你使用的訓練集是否包括客戶群中的每一個人? 如果沒有,你是否測試了與樣本無關的用戶數據?你的AI團隊中的其他人怎麼樣?他們是包容的、多樣化的、對識別偏見敏感的人嗎?

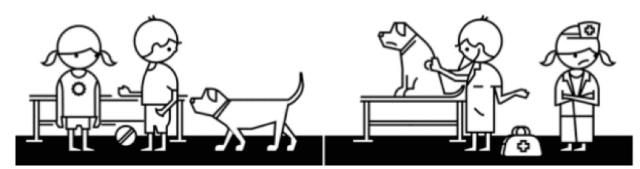

2. 聯想的偏見

還記得孩子們喜歡的 “醫生護士”的遊戲嗎?一些男孩喜歡當醫生,他們認為女孩應該去當護士。女孩如果也想當醫生就必須推翻男孩的聯想:“嘿,女孩也可以是醫生!”

定義:用於培訓AI模型的數據中增加或增強了一種文化偏見。在訓練人工智能算法時,人類偏見可對機器學習產生影響。在未來的人機互動中如果繼續保持這些偏見,可能會導致不公平的用戶體驗。

產品示例:以性別假設工作的語言翻譯工具。它認為飛行員是男性,空乘人員是女性。

壓力測試: 你的訓練結果是否讓團隊定性了性別或種族?你能做什麼打破機器不健康、不公平的聯想?你的數據集已經分類並貼上標簽了嗎?

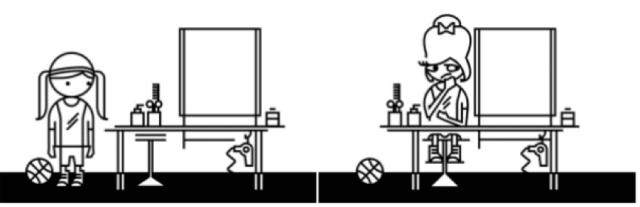

3. 自動化的偏見

有的女孩喜歡運動,喜歡自然的外表,討厭任何做作的東西。但美容師並不認為她這樣很美,於是給她改頭換麵,用上大量化妝品,打造複雜的發型。結果美容師很高興,被打扮的女孩卻感到恐懼。

定義:AI自動決策超越了人類社會和文化因素。預測程序自動實現的目標違背了人類多樣性。這些算法並不是從對人類負責的角度做出決定的,而是受到人類的影響做出決定。AI設計師和從業人員需要考慮他們所構建的係統是否影響人的決策。

產品示例:美圖軟件中的濾鏡強化了歐洲人對美容的觀念,如減輕膚色。

壓力測試:多樣化的用戶是否同意你的算法得出的結論?你的AI係統是否越權,排除人類選擇,讓人們去支持自動決策?你如何確保AI係統中一直有人的觀點?

4. 交互的偏見

“打電話”是一個很受孩子們歡迎的遊戲。第一個人先對第二個人貼耳低聲說一句話,然後第二個人再這樣傳話給第三個人……直到最後一個人說出他所聽到的。這個遊戲的目的是正確地在多個環節中傳遞信息。如果其中一個孩子故意變個說法,創造了錯誤的結果,最終可能引來大家的捧腹大笑。看起來很有趣,但現實中出現這種情況可能會讓我們精神崩潰。

定義:人們刻意篡改人工智能並令其產生帶有偏見的結果。現在的聊天機器人就可以開玩笑,愚弄人們,讓人們感覺它們是人類。但這些試圖將人工智能人性化的嚐試,卻無意中給電腦程序帶來了許多有害的人類偏見。當聊天機器人在沒有約束的情況下相互動態學習時,產生的交互偏見就會越來越大。

產品例子:被人們灌輸了種族主義或性別歧視意識的聊天機器人,被訓練得可以說出攻擊性言論。

壓力測試: 你是否已經仔細檢查過係統中沒有惡意篡改的傾向?你的人工智能係統向人們學到了什麼?你隻是單純設計了實時互動和學習嗎?你知道這意味著什麼嗎?

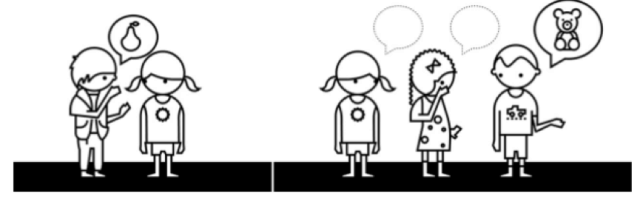

5. 認識上的偏見

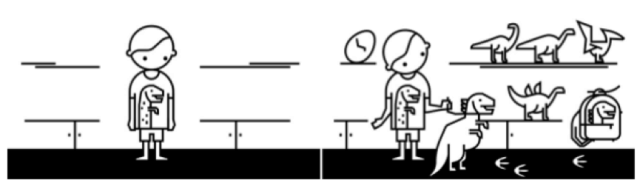

如果孩子買了一件恐龍玩具,他的爺爺奶奶姥姥姥爺七大姑八大姨看到了,以為他喜歡,就會去給他買更多的恐龍玩具。沒過幾年,親戚朋友都以為這孩子是恐龍玩具的“腦殘粉”,又給他不停地買買買,直到裝不下為止。

定義:簡單粗暴的個性化會對一個群體或個人產生偏見。認識上的偏見會以一種先入為主的方式來解釋信息。一旦AI算法提供的內容與用戶某次不經意的選擇相匹配,那用戶就看不到別的不匹配結果了。接受AI推薦的人永遠看不到那些與自己三觀不同的觀點,同時也看不到被AI屏蔽了的替代方案和不同的想法。

產品示例:含有產品推薦的購物網站,總是推薦人們已經購買過的東西。

壓力測試:你的算法是否建立並強化隻有流行偏好?隨著客戶的不斷變化,你的AI係統能否根據用戶的改變動態演進?你的AI係統能否幫助客戶對世界有更多元、更包容的看法?

如何使用以上指南

作為人工智能產品體驗的設計者和創造者,我們需要深思人工智能的發展以及它如何影響真實的人。上述指南隻是為每個人提供平等體驗的開始。

如果把這些想法用到文章開篇的例子中,就可以把這件事標記為數據集偏見:軟件接受的數據太片麵。通過認識和理解這些偏見,我們可以測試係統與人類思維的差別,並建立更具包容性的體驗。我們的麵部識別軟件是否受製於故意導入的錯誤數據?還有哪些偏見會影響產品體驗?

在人工智能領域工作的大多數人都遇到過偏見問題。不過令人尷尬的是,無意識的偏見會產生令人不快的結果,盡管我們都想識別和避免。本文的目標就是幫助你識別導致這種情況的潛在偏見。通過上述方法測試你大腦中是否產生過這些偏見,這樣你就可以專心地將AI的潛力傳遞給所有的用戶了。

—完—

相關資訊

最新熱門應用

avive交易所官網最新版

其它軟件292.97MB

下載

必安交易所app官網版安卓

其它軟件179MB

下載

富比特交易所app安卓版

其它軟件34.95 MB

下載

美卡幣交易所安卓版

其它軟件16.3MB

下載

幣幣交易所app官網

其它軟件45.35MB

下載

熱幣交易所最新版本app

其它軟件287.27 MB

下載

zbg交易所官方ios

其它軟件96.60MB

下載

拉菲交易所安卓版

其它軟件223.89MB

下載

ceo交易所app

其它軟件45.59MB

下載

zbg交易所app安卓版

其它軟件225.08MB

下載