在演唱會 “抓逃犯” 上屢建奇功的人臉識別,其實還是不成熟的技術,具體表現在對膚色和性別的歧視上。

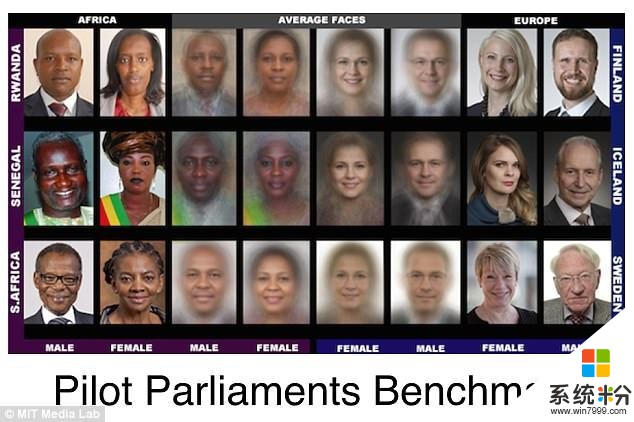

微軟發現,商用人臉識別識別膚色較淺的男性準確率最高,而失誤率最嚴重的是膚色較深的女性。

這可算是人臉識別的 “技術偏見” 了。

這種偏見一旦在大範圍應用中 “顯現”,聲討種族和性別 “歧視” 的聲音,將會淹沒微軟。

為了解決充滿偏見的技術,微軟 Face API 團隊對其識別係統進行了三次重大改進。最新的人臉識別係統,識別膚色較深的人錯誤率降低了 20 倍,識別所有女性的失誤率減低了 9 倍。

盡管有了改進,但目前的人臉識別,還不是完美的係統。微軟認為,問題的根本解決辦法還是訓練數據庫,需要收集更多的數據,包括不同膚色、發型和麵部飾品等。

▲ 研究發現,微軟和 IBM 的識別黑人女性出錯率高. 圖片來自:Daily Mail

中國人普遍的黃皮膚,剛好避開了 “最淺” 和 “最深” 的膚色。但我國也有外貌特征各異的少數民族,如果人臉識別對此產生技術偏見,就不是簡單的 “開地圖炮” 了,可能會引發嚴重的民族矛盾。

至於 “更大範圍攻擊” 的性別歧視話題,在我國也變得非常敏感,該慶幸人臉識別技術目前還沒有惹來 “性別歧視罵戰”。

偏見的鍋不能完全甩給人工智能,技術也是反映真實社會的鏡子。

微軟研究實驗室的高級研究員、AI 係統公平性專家 Hanna Wallach 在一份聲明中回應:

如果我們訓練機器學習係統使用有偏見的社會產生的數據,來模擬那個社會做出決定,那麼這些係統必然會重現它的偏見。

例如,在一些社區中,黑人的犯罪率更高,AI 根據收集來的數據,更容易把膚色較深的人劃分到 “逃犯” 的分類中。這是群體給個體的傷害,人臉識別隻不過 “遵循了” 社會偏見。

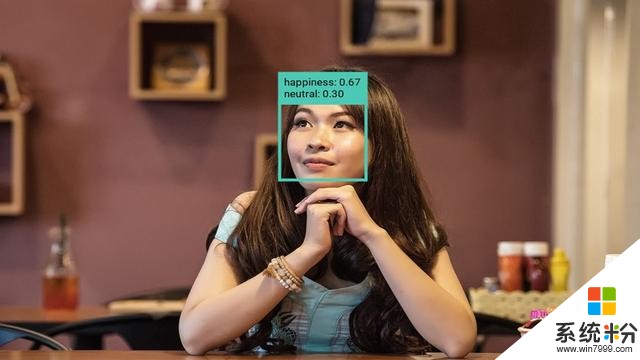

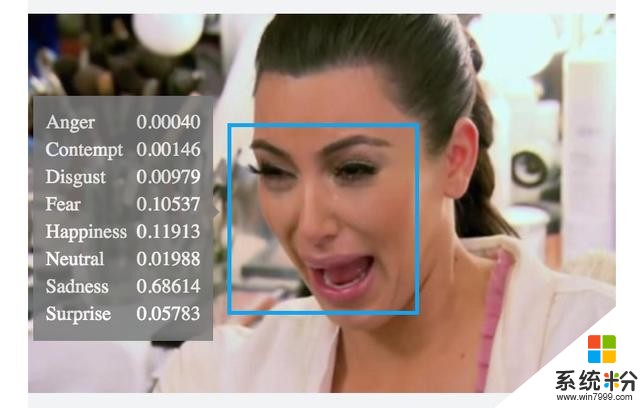

▲ 微軟人臉識別的情緒檢測功能. 圖片來自:thenextweb

相比起導致 “歧視”,研究團隊更希望 AI 能檢測和減輕偏見,以彌補現實社會中的不完美。

追捕逃犯用大範圍攻擊的 “種族炮” 和 “性別炮” 容易傷及無辜,人臉識別的方向是更精密的 “狙擊槍”。

一直對人臉識別技術保持警惕的美國,其海關部門也要啟用人臉識別係統,但收到強烈的反對。

關於人臉識別,最近亞馬遜的幺蛾子也很多,先是美國公民自由聯盟向亞馬遜提交請願信,接著 100 多名內部員工也要求首席執行官 Jeff Bezos 停止向美國警方出售人臉識別軟件。目前,美國奧蘭多市警察局與亞馬遜的人臉識別合同已過期,雙方還沒決定續約。

“亞馬遜人” 簽署的部分內容:

我們公司不應該在監控業務中; 我們不應該參與警務工作; 我們不應該從事支持監督和壓迫邊緣化人群的人;

▲ ICE 將啟用微軟人臉識別軟件. 圖片來自:Inc.

盡管微軟員工與亞馬遜員工的想法一致,堅決認為人臉識別軟件侵犯人權,對美國最近的移民政策尤其不滿,希望微軟 CEO Satya Nadella 停止與 ICE (美國移民和海關執法部門) 簽署協議,但目前仍沒收到成效。

人臉識別技術到底帶來了安全保障,還是帶來了歧視,侵犯了個人自由?美國科技公司們的 “糾結”,也許值得我們思考,看演唱會被人臉識別,到底是不是妥當的?

題圖來源:Gigaom

相關資訊

最新熱門應用

芝麻交易平台官方安卓版

其它軟件223.89MB

下載

易歐交易所app官網安卓蘋果

其它軟件397.1MB

下載

滿幣交易所app

其它軟件21.91MB

下載

天秤幣交易所蘋果app

其它軟件88.66MB

下載

wbf交易所

其它軟件68.68M

下載

歐意交易所蘋果app

其它軟件397.1MB

下載

kbcoin交易所官方版

其它軟件1.93 MB

下載

美幣交易所app蘋果版

其它軟件68.51MB

下載

bkex幣客官網交易所手機版

其它軟件292.97MB

下載

icash交易所

其它軟件223.86MB

下載