編者按:2018年的SIGGRAPH Asia大會於12月4日-7日在日本東京召開,在本屆大會上,微軟亞洲研究院共有5篇論文被接收,論文內容涵蓋利用深度學習來實現從人像照片到肖像漫畫的風格遷移,根據用戶手畫草圖生成三維模型的新方法,借助無監督學習進行圖像平滑處理等一係列最新研究。

下麵就讓我們一起來看看這幾篇論文都研究了哪些內容吧。

從照片到漫畫數據驅動的深度學習AI

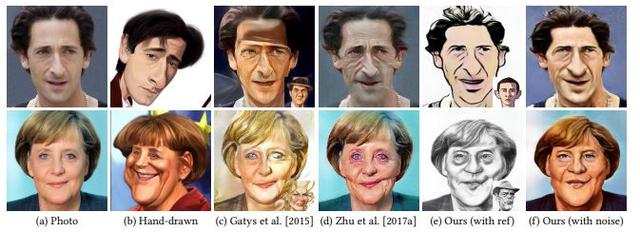

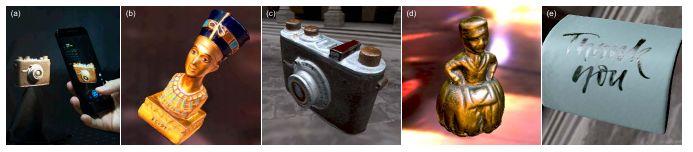

根據人物照片創作漫畫對於藝術家來說很容易,但是繪畫中細節的複雜性和形狀的不確定性,對於AI而言卻是十分困難的。來自微軟亞洲研究院的實習生和研究員們設計了一種基於深度學習的方法——CariGANs,它從專業藝術家繪製的數千幅漫畫中學習,可以根據人物肖像照片自動合成漫畫。 現有的風格轉移方法主要著重在外觀風格上,而這種新技術在此基礎上還可以模擬漫畫中常見的幾何誇張手法。

這項技術將生成式對抗網絡(GAN)應用於人物圖片與人像漫畫之間的轉化,並保留人物肖像的身份特征。CariGANs計算框架包含兩個子算法——CariGeoGAN和CariStyGAN。CariGeoGAN用於構造從麵部照片到漫畫的幾何變形,CariStyGAN則在不引入幾何變形的同時,將漫畫的風格轉移到麵部照片。兩個網絡針對每項任務分別進行訓練,因此學習過程更加魯棒。用戶能夠通過拖動或給出示例漫畫的方式,來控製幾何和外觀風格的誇張程度。

該研究還通過感知研究來評估他們的框架是否能夠生成易於識別且不會在形狀和外觀風格上過度扭曲的肖像漫畫。例如與現有的漫畫風格遷移方法相比,CariGANs能在多大程度上保留肖像的身份特征。研究人員通過實驗發現,現有的方法所得到的漫畫常常過於誇張或不夠清晰,因而人物難以被識別。而CariGANs能夠將肖像照片轉化為更清晰、更準確的漫畫,就如同專業藝術家創作的一般。

目前,這項工作主要是針對頭像或半身像的人物漫畫。該技術已經可以幫助用戶創作用於社交媒體的人像漫畫和構建有趣的卡通形象。在未來,研究人員將針對全身像和更複雜的場景進行漫畫生成,並進一步增強這一係統的人機交互功能。希望這項技術可以應用於市場營銷、廣告和新聞等更多領域。

論文鏈接:

http://ai.stanford.edu/~kaidicao/carigan.pdf

基於草圖的自由三維形狀建模

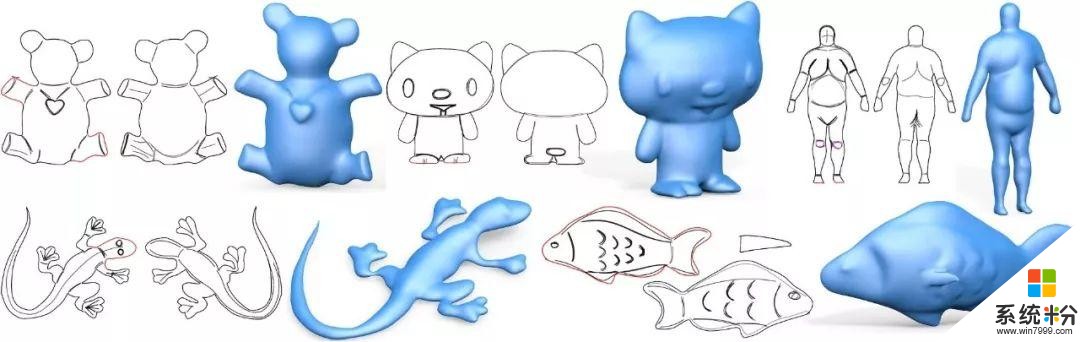

通過繪製草圖來建模三維形狀是計算機圖形學的經典問題。關於該問題,現有工作可以分為兩類,一類是基於幾何推理的方法,另一類是基於機器學習的方法。在過去的二十年中,研究人員開發出有效的幾何規則,基於此類規則,用戶繪製的2D草圖可以準確地轉換為3D模型。這些基於深刻幾何原理的方法雖然強大,但通常需要大量用戶標注才能實現內容的複雜性,並且由於涉及非線性優化,計算速度通常較慢。隨著機器學習方法的成熟,特別是卷積神經網絡(CNN)等深度學習方法,近年來出現了基於CNN的、采用數據驅動的方法來解決草圖建模問題。這些方法通常收集包含特定類型的物體及其相應草圖的大型數據集,並訓練一個卷積網絡實現從草圖到3D形狀的映射。但是針對特定類別物體訓練出來的網絡無法推廣到其它類別。

針對以上兩種方法的不足之處,香港大學和微軟亞洲研究院的研究員開發了一種智能的方法,它需要極少的用戶標注,可以自動執行所需推理,而且不必為每個特定的物體類別訓練單獨的機器學習模型。

新的方法是以上兩種方法的結合。基於幾何原理,新方法將從草圖到三維物體的問題分解為:(1)從草圖獲得密集的曲率方向場,(2)而後從草圖和曲率場重建出無特定類別的自由形狀。另一方麵,新方法通過數據驅動的卷積網絡進行幾何推理,包括如何解析不含標注的草圖和重建曲率方向場,以及如何進一步重建自由曲麵。實驗證明,使用大規模的合成數據訓練的卷積網絡可以很好地處理人們真實繪製的草圖,並非常快速地生成符合用戶期望的三維形狀。

基於草圖建模的主要技術難點在於二義性,即2D草圖和3D形狀之間存在明顯的信息差異。幾何推理方法在很大程度上依賴於詳細的用戶標注來解決二義性,而先前的數據驅動方法通過限製到特定物體類別來減少二義性。新提出的方法則是通過數據驅動來盡可能減少用戶標注,將草圖轉換為密集曲率方向場以提供正則化,並且使用無監督學習顯式建模關於三維重建的置信度,以對抗二義性。

借助該新方法,藝術家可以快速輕鬆地繪製三維自由形狀,然後使用其他建模軟件進一步增加物體的細節。普通用戶也可以使用它進行3D創作。

論文鏈接:

http://haopan.github.io/papers/SketchCNN.pdf

利用無監督學習框架的圖像平滑

圖像平滑是計算機視覺和圖形圖像處理裏眾多算法中的一個重要組件。來自山東大學、北京大學和微軟亞洲研究院的研究員提出了一個統一的無監督學習框架,該框架利用深度卷積神經網絡從數據中學習,可以提供靈活且高質量的圖像平滑效果。

該框架在目標函數裏引入兩個特別的能量項:(1)邊緣保持正則項,用以保護重要但脆弱的圖像結構;(2)空間自適應Lp光滑項,可以將不同形式的正則化自適應地施加到圖像的不同區域,以獲得更好的平滑質量。基於該統一的框架,研究人員實現了一套多樣化的圖像平滑解決方案,並應用於圖像抽象、鉛筆素描風格化、細節增強、紋理去除和內容相關的圖像處理等方麵,取得了與以往方法相當乃至更好的結果。另外由於GPU的使用,該方法使得圖像平滑計算極為高效,在1280x720 分辨率的圖像上可達到200幀每秒的速度。

論文鏈接:

https://arxiv.org/pdf/1811.02804.pdf

自適應八叉樹卷積神經網絡

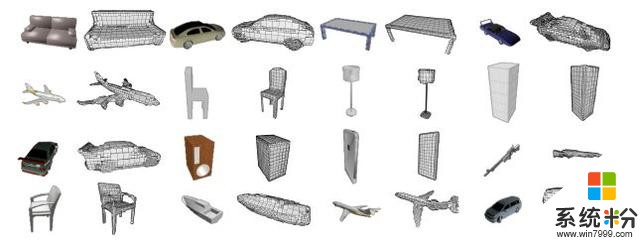

微軟亞洲研究院的研究員和來自清華大學的實習生提出了一種基於自適應八叉樹的卷積神經網絡——Adaptive O-CNN,以用於高效的三維形狀的編解碼任務。傳統的基於體素和基於八叉樹的三維表達將三維信息存儲於相同分辨率的體素中,而基於自適應八叉樹的表達根據八叉樹結點內三維形狀是否可以被平麵片很好地逼近這一原則,將三維形狀自適應地分解到不同層的八叉樹結點中,從而具有更稀疏更緊致的三維表達。基於這種表達,研究人員構造了高效的自適應的O-CNN編碼器和解碼器,以此來編解碼三維形狀。 具體而言, Adaptive O-CNN 編碼器以自適應八叉樹結點內的擬合平麵的參數作為輸入,僅在八叉樹節點上進行三維卷積;Adaptive O-CNN解碼器預測空間如何剖分以生成自適應八叉樹,並估算出自適應八叉樹各層非空葉結點中的擬合平麵以構造三維形體。作為三維形狀分析和生成的通用框架, Adaptive O-CNN 不僅大幅降低了GPU內存開銷和計算成本,而且其三維生成的質量還優於很多現有的基於深度學習的方法。研究人員在一係列應用中展示了Adaptive O-CNN在三維形狀分析與生成的能力和優越性,其中包括形狀分類、三維自動編碼器、基於單張圖像的三維形狀生成,以及對含噪聲和缺失信息的三維點雲的形狀補全。

論文鏈接:

https://wang-ps.github.io/AO-CNN_files/AOCNN.pdf

偏振SVBRDF和法向信息的同時采集

物體的表觀模型獲取通常要在光線-視點空間中進行密集采樣,而且這樣的采樣需要利用非常特定和昂貴的硬件來實現。為了降低采集難度和開銷,韓國KAUST大學和微軟亞洲研究院的學者利用了光的偏振特性,實現了一個無需多個光和視點角度的采集係統。他們在單個的投影儀和相機前放置線性偏振鏡來拍攝一組偏振圖像,以獲得真實物體的表觀和法向信息。

在這個係統的設計中研究人員遇到兩個技術挑戰:(1)沒有同時考慮鏡麵反射和漫反射的完整的偏振BRDF模型;(2)現有的基於偏振的逆向渲染方法是基於球麵光照的假設, 它們不適用於局部光照情況。針對這些問題,研究人員首次提出了一個完整的pBRDF模型,用來描述鏡麵反射和漫反射的偏振光強分布。基於pBRDF模型,研究人員也提出一種基於 pBRDF和法向量聯合優化的新的逆向渲染方法,該方法能夠捕獲隨空間變化的材質表觀: 材質的鏡麵特性(包括折射率、鏡麵粗糙度和鏡麵係數)、每個像素的漫反射率和法向值等。研究人員通過計算偏振表觀和幾何特性之間的物理關係,解決了之前嚴重病態的逆向渲染問題。

論文鏈接:

http://vclab.kaist.ac.kr/siggraphasia2018p1/multiview_author.pdf

你也許還想看:

,共建交流平台。來稿請寄:msraai@microsoft.com。

相關資訊

最新熱門應用

虛擬幣交易app

其它軟件179MB

下載

抹茶交易所官網蘋果

其它軟件30.58MB

下載

歐交易所官網版

其它軟件397.1MB

下載

uniswap交易所蘋果版

其它軟件292.97MB

下載

中安交易所2024官網

其它軟件58.84MB

下載

熱幣全球交易所app邀請碼

其它軟件175.43 MB

下載

比特幣交易網

其它軟件179MB

下載

雷盾交易所app最新版

其它軟件28.18M

下載

火比特交易平台安卓版官網

其它軟件223.89MB

下載

中安交易所官網

其它軟件58.84MB

下載